本次openai开源的两款模型,主打的就是高性能与高效率的结合,并以宽松的Apache 2.0许可证发布,企业可免费商用。

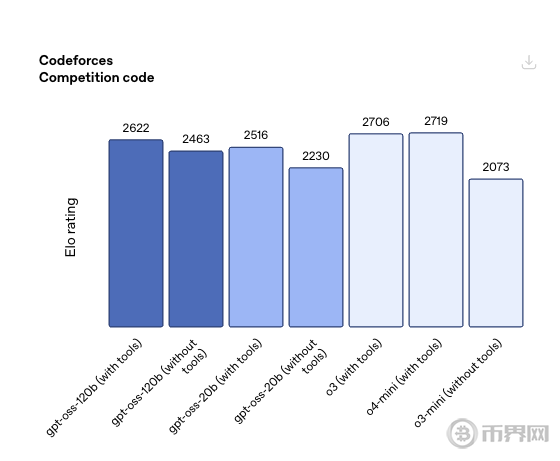

gpt-oss-120b:这是一款拥有1170亿总参数的MoE(混合专家)架构模型。其性能在多项基准测试中表现出色,但与自家的闭源模型相比,仍有差距。例如,在编程测试中,其得分虽高于一些头部开源模型,但仍不及o4-mini。

gpt-oss-20b:这是一款拥有210亿总参数的轻量级版本,性能与o3-mini相当。它对硬件的要求极低,仅需16GB内存即可在消费级笔记本电脑上运行。

然而,高效的背后是需要注意的性能权衡。OpenAI坦言,由于较小的模型拥有的世界知识更少,这两款开源模型会产生更多的“幻觉”。在衡量模型对人物知识准确性的内部测试(PersonQA)中,gpt-oss-120b和gpt-oss-20b的幻觉比例分别高达49%和53%,是其初代模型o1的三倍多,也显著高于o4-mini的36%。

模型发布后,社区反响热烈。许多开发者和用户上手体验后的第一个直观感受就是——快!

有网友在搭载M3 Pro芯片的Mac上本地部署了20b版本,实现了接近每秒24 tokens的高速推理。AI芯片厂商Cerebras更是宣布,其硬件能将120b版本的推理速度拉到惊人的每秒超3000 tokens,创下了OpenAI模型的最快纪录。

然而,在一片赞誉声中,质疑也随之而来。许多开发者指出,OpenAI的此次“开源”并不彻底。虽然模型权重是公开的,但其预训练的数据构成、强化学习的技术细节等关键信息都未披露,这使得开源社区难以从中借鉴和复现其训练过程。

此外,OpenAI在所有公布的基准测试中,都有意回避了与市场上其他主流模型的直接对比,无论是DeepSeek、Qwen、Kimi等强大的开源对手,还是Claude、Grok、Gemini等闭源竞争者,这让外界对其真实的市场竞争力打上了一个问号。

为了实现高性能与高效率的平衡,gpt-oss系列模型采用了先进的MoE架构,在处理每个token时,120b版本仅需激活51亿个参数。同时结合了分组多查询注意力、旋转位置嵌入(RoPE)等技术。

更重要的是,OpenAI此次开源显然是有备而来,其背后是强大的产业生态支持。模型发布后,已有至少14家主流部署平台宣布支持,包括Hugging Face、Azure、AWS、Vercel、Ollama等,为开发者提供了极其便利的部署环境。

在硬件方面,除了英伟达和AMD的全面支持外,Cerebras和Groq等AI芯片新贵也纷纷展示了其惊人的推理速度,显示出OpenAI在推动模型落地应用上与硬件厂商的深度合作。

总结本次的openai开源事件,我们可以看到,作为行业领导者,OpenAI在过去很长一段时间里因其“Open”之名与闭源之实而备受诟病。此次时隔6年再度开源语言模型,无疑是对外界质疑的有力回应,也是其战略布局的重要一步。

从实际效果来看,gpt-oss系列模型主打轻量化和高效部署,并已与云厂商、芯片厂商建立v起深度的合作生态,这无疑将极大地推动其在企业和个人开发者中的普及。不过,由于其在技术细节上的保留以及更高的幻觉率,开源社区能否真正从中获益,仍有待时间的检验。

OpenAI 的开源举动以及 gpt-oss 模型的发布,不仅是 AI 领域的重大事件,也预示着 AI 技术将与 Web3 深度融合,共同重塑去中心化应用和数字经济的未来。在这样一个技术前沿、创新加速且潜在风险并存的时代,用户对数字资产的自主掌控、对新兴 AI 驱动应用的便捷安全交互,以及对隐私的全面保护显得尤为重要。Boss Wallet,作为一款以用户为中心、强调极致安全的去中心化钱包,正是为赋能用户安全、便捷、自主地参与这场 AI 与 Web3 融合的浪潮而设计。

Boss Wallet 是一款真正的非托管钱包,将极致资产主权置于核心。随着 AI 模型和应用日益与 Web3 结合,数据、资产和控制权可能会再次面临中心化或不透明的挑战。Boss Wallet 确保您的所有数字资产私钥完全由您自己掌控,不托管于任何第三方。这意味着无论新兴的 AI 驱动 DApp 或其背后的公司如何演变,您的资产始终安全地存储在您的个人钱包中,彻底规避了平台风险,保障了您在参与 Web3 创新时的最终资产安全和数字主权。