去中心化GPU网络将自身定位为运行AI工作负载的低成本层,而最新模型的训练仍然集中在超大规模数据中心内。

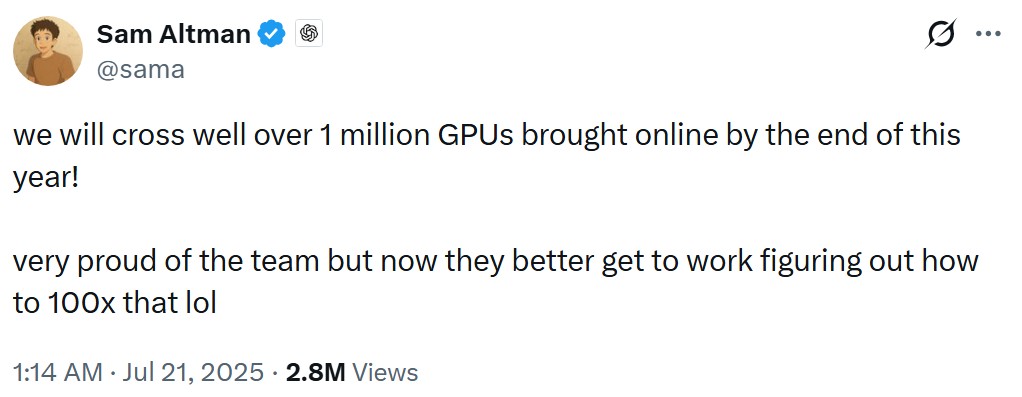

前沿AI训练涉及构建最大、最先进的系统,这一过程需要数千枚GPU高效协同运行。

这种级别的协作使得去中心化网络在顶级AI训练中难以实现,因为互联网的延迟和可靠性无法与集中式数据中心中高度耦合的硬件相提并论。

大多数生产环境下的AI工作负载并不类似于大规模模型训练,这为去中心化网络承接推理和日常任务提供了空间。

“我们现在开始看到,很多开源及其他模型已经足够精简且优化,可以高效地在消费级GPU上运行。”Theta Network联合创始人兼首席执行官Mitch Liu向Cointelegraph表示,“这正在推动整个行业向开源、更加高效的模型以及更具经济效益的处理方式转变。”

前沿训练主要集中在少数超大规模运营商手中,因为运行大型训练任务的成本和复杂度极高。最新的AI硬件,例如Nvidia的Vera Rubin,被设计用于优化集成数据中心环境下的性能。

“你可以把前沿AI模型的训练比作建造一座摩天大楼,”基础设施公司Ovia Systems(前身为Gaimin)首席执行官Nökkvi Dan Ellidason对Cointelegraph表示,“在集中式数据中心,所有工人都在同一个脚手架上,手动传递砖块。”

这种一体化程度使分布式网络中常见的松散协作和延迟波动几乎没有空间。

“如果要在去中心化网络中建造同样的摩天大楼,他们必须通过开放互联网把每块砖邮寄给对方,这效率极低。”Ellidason补充道。

Meta训练其Llama 4 AI模型时,使用了超过10万枚Nvidia H100 GPU组成的集群。OpenAI未披露用于模型训练的GPU集群规模,不过其基础设施负责人Anuj Saharan表示,GPT-5上线时获得了超过20万枚GPU的支持,但并未具体说明这些算力中有多少用于训练,多少用于推理或其他工作负载。

推理指的是运行已训练模型,为用户和应用生成响应。Ellidason称,AI市场已达到“推理临界点”。虽然在2024年GPU需求仍以训练为主,他估计到2026年,推理、智能体和预测型工作负载将推动多达70%的需求。

“这让算力从研究成本转变为持续扩张的公用事业成本,”Ellidason说,“因此,内部循环驱动的需求倍增效应使去中心化计算在混合架构中成为可行选项。”

去中心化GPU网络最适合于可以分割、路由并独立执行的工作负载,无需机器间持续同步。

“推理是一个体量巨大的业务领域,并且会随着每个部署的模型和智能体回路而扩张,”去中心化计算平台Fluence联合创始人Evgeny Ponomarev对Cointelegraph表示,“在这个领域,成本、弹性和地理分布比完美互联更为重要。”

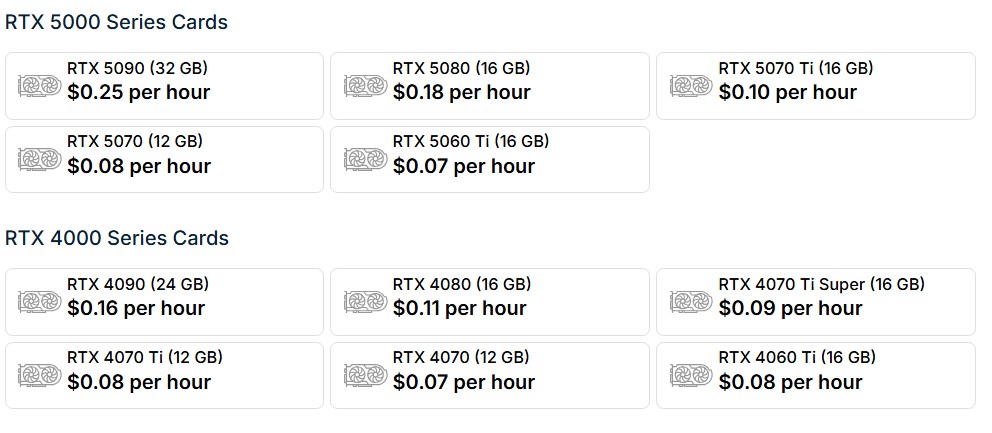

实际上,这意味着消费级环境下的去中心化GPU和游戏级GPU对于追求吞吐量和灵活性、而非高度协调的生产工作负载更加合适。

“消费级GPU VRAM较低且家庭网络连接环境下,既不适合训练,也不适合对延迟极为敏感的负载,”闲置消费级GPU聚合平台Salad Technologies首席执行官Bob Miles对Cointelegraph说。

“现在,它们更适用于AI药物发现、文本生成图像/视频、大规模数据处理等对成本敏感的场景——在价格与性能方面,消费级GPU具有优势。”

去中心化GPU网络同样适合于采集、清洗、准备训练数据等任务。这类任务常常需要广泛访问互联网,并可在无须紧密协调的情况下并行运行。

Miles表示,这类工作在没有大量代理层基础设施的前提下,在超大规模数据中心内高效运行难度较大。

当服务全球用户时,去中心化模型具备地理优势,因为它可以减少用户请求到数据中心所需的物理距离和多次网络跳转,从而降低延迟。

“在去中心化模式中,GPU分布在全球众多地点,通常更接近终端用户。因此,用户与GPU之间的时延明显较低,优于统一将流量路由至集中式数据中心,”Theta Network的刘明杰表示。

Theta Network正面临两名前员工在2025年12月于洛杉矶地区提起的欺诈及代币操控相关诉讼。刘明杰称目前诉讼尚未终结,因此无法置评。Theta此前已否认相关指控。

前沿AI训练在可预见时期内仍将保持集中化,但AI计算正逐步转向推理、智能体以及需较松散协作的生产负载。这类工作负载更加注重成本效率、地理分布和弹性。

“本轮周期出现了大量虽不及ChatGPT规模,但运行在配备RTX 4090或5090等GPU个人电脑上的开源模型,”Theta技术负责人Jieyi Long对Cointelegraph表示。

Long指出,借助该级别硬件,用户可以本地运行扩散模型、3D重建模型以及其它有意义的工作负载,这为零售用户共享自身GPU资源创造了机会。

去中心化GPU网络并非超大规模运营商的替代方案,但正逐渐成为AI算力结构中的互补层。

随着消费级硬件不断升级、开源模型愈发高效,越来越多AI任务逐步从集中式数据中心外溢,让去中心化模型在AI体系中占据一席之地。