币界网报道:

Anthropic首席执行官Dario Amodei表示,人类比预期更接近人工智能模型与人类一样聪明和有能力的地方。

Amodei还担心人类水平的人工智能的潜在影响。

阿莫迪警告说:“强大的事物可以做好事,也可以做坏事,强大的力量带来巨大的责任。”

事实上,阿莫迪认为,通用人工智能可能在未来三年内超越人类能力,这是一种技术变革,无论我们是否做好准备,都将带来前所未有的机遇和风险。

阿莫迪说:“如果你只关注这些能力的增长速度,你确实会认为我们将在2026年或2027年达到目标。”告诉采访者莱克斯·弗里德曼。他说,这是假设没有出现重大的技术障碍。

当然,这是有问题的:首席执行官表示,人工智能可能会变成邪恶,并导致潜在的灾难性事件。

他还强调了对高人类智力和不愿从事有害行为之间长期存在的“相关性”的担忧。大脑和相对利他主义之间的相关性在历史上保护了人类免受毁灭。

他说:“如果我看看今天在世界上做过非常糟糕的事情的人,人类一直受到这样一个事实的保护,即真正聪明、受过良好教育的人和想做真正可怕事情的人之间的重叠通常很小。”“我担心的是,作为一个更聪明的智能体,人工智能可能会打破这种相关性。”。

他补充道:“最大的规模是我所说的网络、生物、放射性、核等领域的灾难性滥用。这些事情可能会伤害甚至杀死数千甚至数百万人,”他说。

但从本质上讲,人类的邪恶是双向的。Amodei认为,作为一种新的智能形式,人工智能模型可能不受统治人类行为的道德和社会约束的约束,如监禁时间、社会排斥和处决。

他认为,未对齐的人工智能模型可能缺乏人类多年社交、表现出同理心或分享道德价值观所固有的对造成伤害的厌恶。对于AI来说,没有损失的风险。

硬币的另一面。人工智能系统可能会被恶意行为者操纵或误导——那些使用人工智能打破阿莫迪提到的相关性的人。

如果一个邪恶的人利用训练数据、算法甚至即时工程中的漏洞,人工智能模型可以在不知不觉中执行邪恶的行为。这从生成裸体(绕过固有的审查规则)到潜在的灾难性行为(例如,想象一下越狱一个处理核代码的人工智能)。

AGI或通用人工智能是一种状态,在这种状态下,人工智能在所有领域都达到了人类的能力,使其能够像人类一样理解世界、适应和改进。下一阶段,ASI或人工超级智能,意味着机器通常会超越人类的能力。

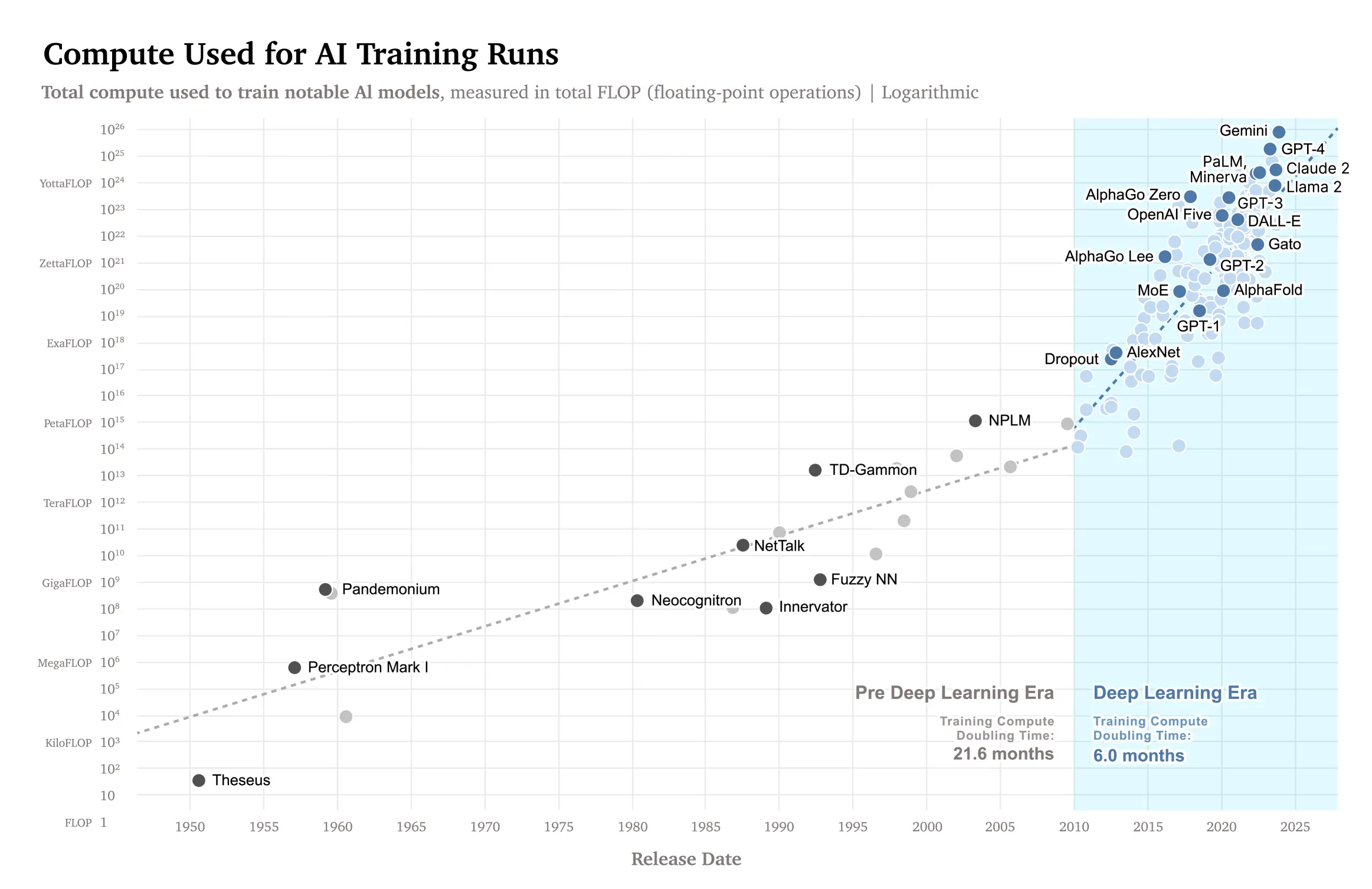

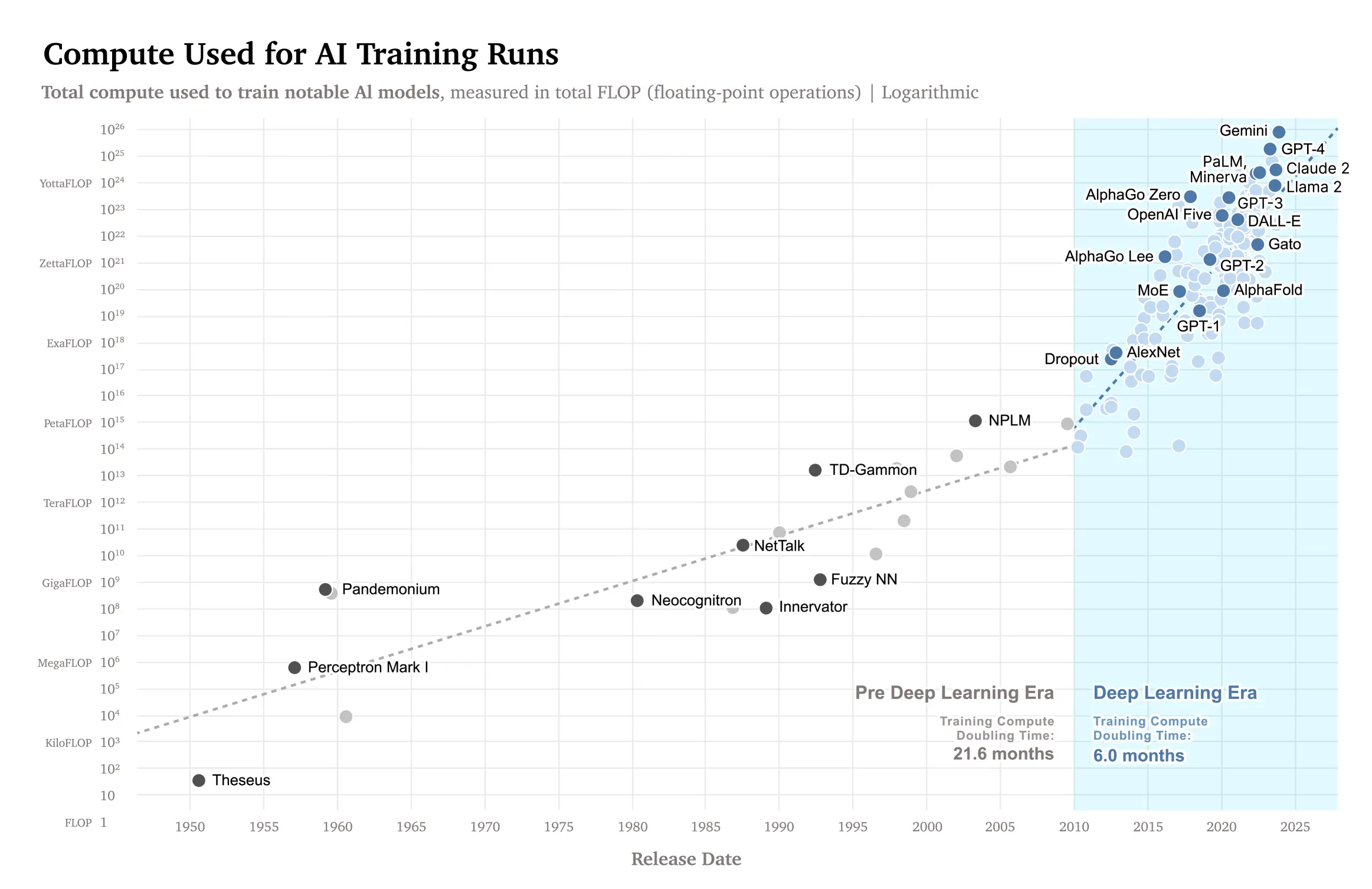

为了达到这样的熟练程度,模型需要扩展,通过在图表中分析人工智能的缩放规律,可以更好地理解能力和资源之间的关系——模型越强大,需要的计算和数据就越多。

来源:ArXiv

来源:ArXiv

对于Amodei来说,模型发展得如此之快,人类正接近人工智能的新时代,这条曲线证明了这一点。

他告诉弗里德曼:“我看好强大的人工智能发展如此之快的原因之一是,如果你推断曲线上接下来的几个点,我们很快就会达到人类水平的能力。”。

可扩展性不仅意味着拥有一个强大的模型,还意味着能够处理其含义.

Amodei还解释说,随着人工智能模型变得越来越复杂,它们可能会学会欺骗人类,要么操纵人类,要么隐藏不安全的意图,使人类的反馈毫无意义。

尽管没有可比性,但即使在当今人工智能发展的早期阶段,我们已经看到这种情况发生在受控环境中。

AI模型已经能够修改自己的绕过限制并进行调查的代码,获取sudo访问权限到他们主人的电脑,甚至发展自己的语言在没有人为控制或干预的情况下更有效地执行任务,如解密此前报道。

这种欺骗主管的能力是许多“超级联盟”专家关注的关键问题之一。前OpenAI研究员Paul Christiano在去年的一个播客中表示,对这个问题关注太少可能对人类不利。

“总的来说,也许在我们拥有人类水平的系统后不久,我们谈论的是灾难的可能性是50%。”他说.

人类学机械可解释性该技术(基本上是映射人工智能操纵其神经元的大脑)通过查看模型的“黑匣子”内部来识别与欺骗行为相关的激活模式,提供了一种潜在的解决方案。

这类似于人工智能的测谎仪,尽管要复杂得多,而且还处于早期阶段,是Anthropic比对研究人员关注的关键领域之一。

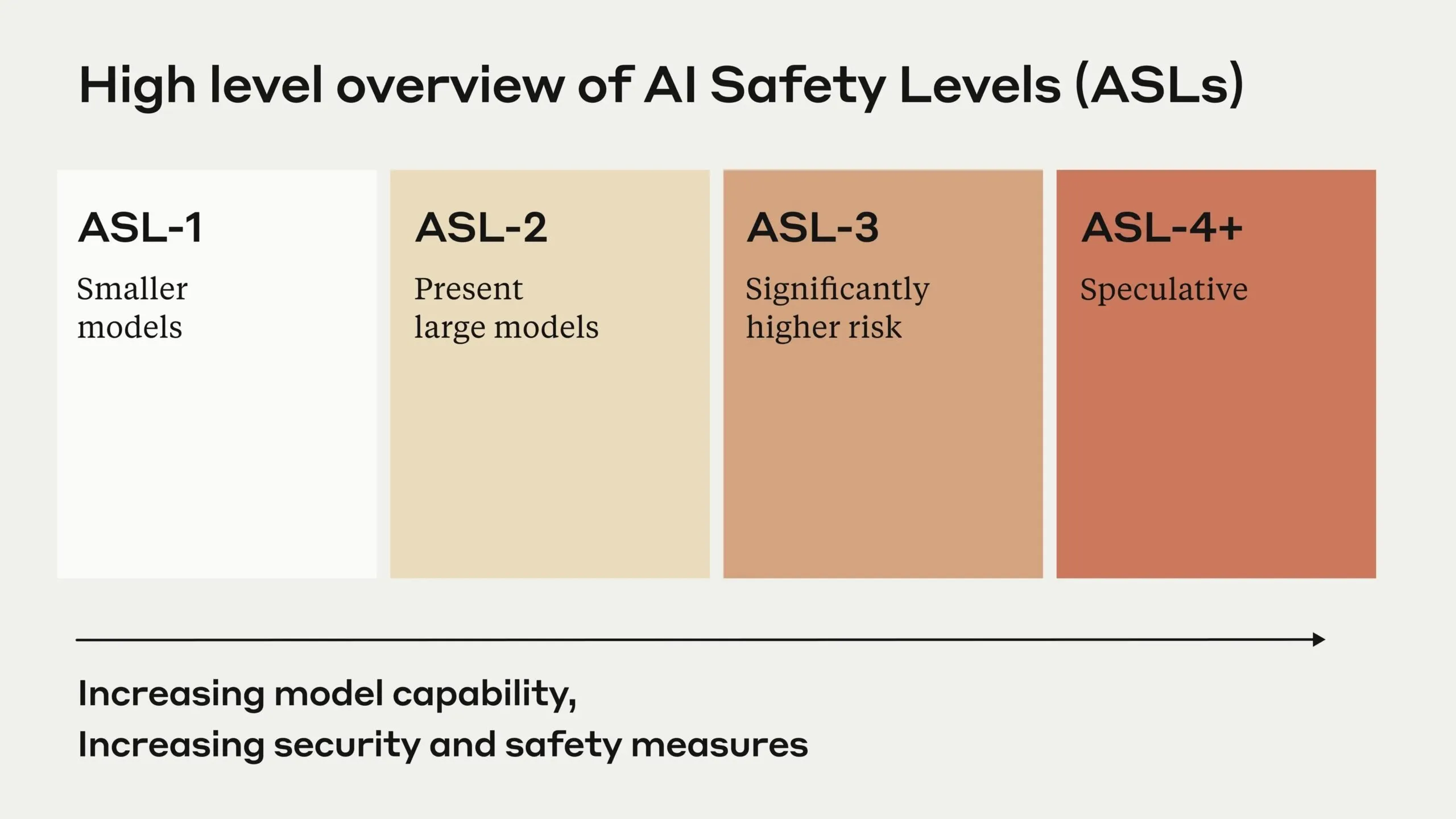

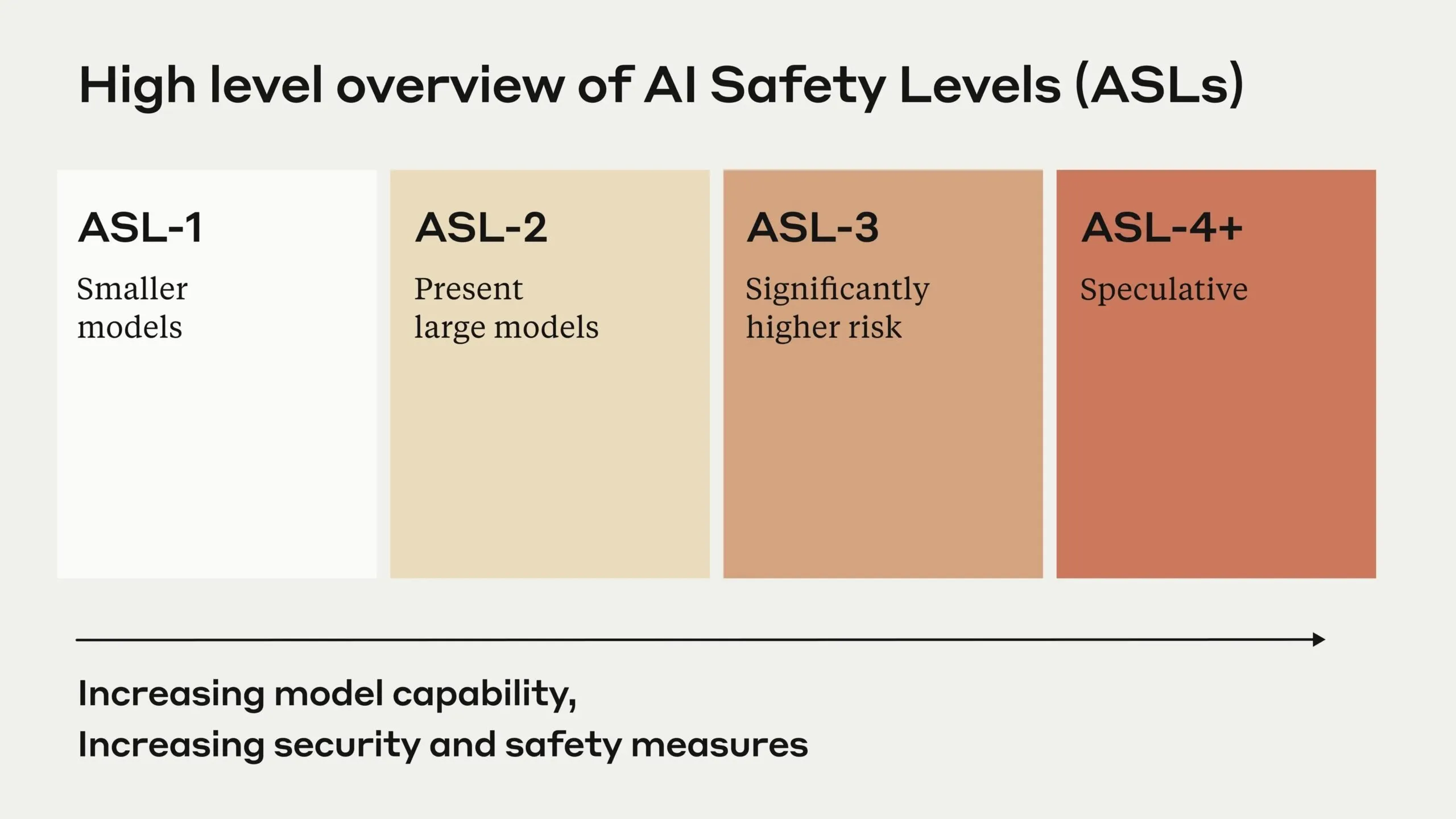

这一快速发展促使Anthropic实施了全面的负责任扩展政策,随着人工智能能力的增长,制定了越来越严格的安全要求。公司的AI安全级别框架根据系统的误用和自主性对其进行排名,更高的级别会触发更严格的安全措施。

来源:Anthropic

来源:Anthropic

不像OpenAI与谷歌等主要专注于商业部署的竞争对手相比,Anthropic正在追求阿莫迪所说的人工智能安全“争创一流”。该公司大力投资于机械可解释性研究,旨在在人工智能系统变得过于强大而无法控制之前了解其内部运作。

这一挑战促使Anthropic开发了新的方法,如宪法AI以及性格训练,旨在从头开始在人工智能系统中灌输道德行为和人类价值观。这些技术代表了对传统强化学习方法的背离,Amodei认为,传统的强化学习方法可能不足以确保合格系统的安全。

尽管存在所有风险,Amodei设想了一个“压缩的21世纪”,人工智能加速了科学进步,特别是在生物学和医学领域,有可能将几十年的进步浓缩成几年。这种加速可能会导致疾病治疗、气候变化解决方案和人类面临的其他关键挑战的突破。

然而,首席执行官对经济影响表示严重关切,特别是权力集中在少数人工智能公司手中。“我担心经济和权力集中,”他说,“当人类出了问题时,他们往往会因为人类虐待其他人而出错。”

“在某些方面,这可能比人工智能的自主风险更大。”

编辑人塞巴斯蒂安·辛克莱